Ein linearer Weg zu effizienten Quantentechnologien

Physik-News vom 18.09.2023

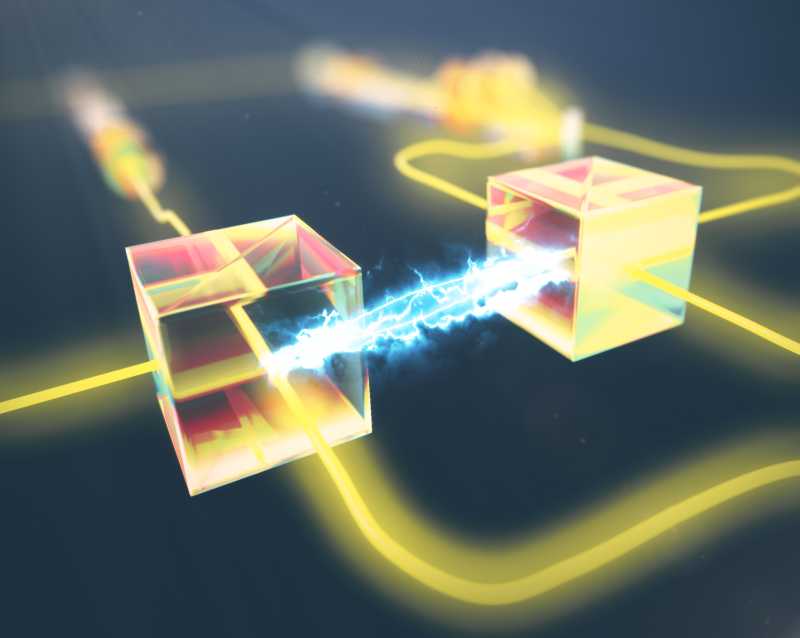

Forschende haben gezeigt, dass eine Schlüsselkomponente für viele Verfahren der Quanteninformatik und der Quantenkommunikation mit einer Effizienz ausgeführt werden kann, die jenseits der üblicherweise angenommenen oberen theoretischen Grenze liegt. Diese Arbeit eröffnet neue Perspektiven für eine breite Palette photonischer Quantentechnologien.

Die Quantenwissenschaft hat nicht nur unser Verständnis der Natur revolutioniert, sondern inspiriert auch bahnbrechende neue Computer-, Kommunikations- und Sensortechnologien. Die Nutzung von Quanteneffekten in solchen Quantentechnologien erfordert in der Regel eine Kombination aus tiefem Verständnis der zugrunde liegenden quantenphysikalischen Prinzipien, systematischen methodischen Fortschritten sowie technologische Innovation.

Publikation:

M. J. Bayerbach, S. E. D’Aurelio, P. van Loock, S. Barz

Bell-state measurement exceeding 50% success probability with linear optics

Science Advances 9, 3209 (2023) Quantum Information & Technology

Und genau diese Aspekte haben die Forscher in der Gruppe von Prof. Stefanie Barz an der Universität Stuttgart und dem Zentrum für Integrierte Quantenwissenschaften und -technologien (IQST) in einer aktuellen Studie kombiniert, in der sie die Effizienz eines zentralen Bausteins vieler Quantengeräte über eine scheinbar inhärente Grenze hinaus verbessert haben.

Von Philosophie zu Technologie

Einer der Protagonisten auf dem Gebiet der Quantentechnologien ist die sogenannte Quantenverschränkung. Der erste Schritt in der Entwicklung dieses Konzepts war eine leidenschaftliche Debatte zwischen Albert Einstein und Niels Bohr. Kurz gesagt ging es darum, wie Informationen über mehrere Quantensysteme hinweg ausgetauscht werden können. Der Kernpunkt ist, dass dies auf eine Art und Weise geschehen kann, die in der klassischen Physik keine Entsprechung hat. Die von Einstein und Bohr angestoßene Diskussion blieb bis in die 1960er Jahre weitgehend philosophisch — bis der Physiker John Stewart Bell einen Weg fand, wie mittels von Experimenten die Meinungsverschiedenheiten gelöst werden können. Bells Theorie wurde zunächst in Experimenten mit Photonen, den Lichtquanten, erforscht. Drei Pioniere auf diesem Gebiet – Alain Aspect, John Clauser und Anton Zeilinger – erhielten im vergangenen Jahr gemeinsam den Nobelpreis für Physik, für ihre bahnbrechenden Arbeiten.

Bell selbst starb 1990, aber sein Name ist nicht zuletzt in den sogenannten Bell-Zuständen verewigt. Letztere beschreiben die Quantenzustände zweier Teilchen, die so stark verschränkt sind wie es möglich ist. Es gibt insgesamt vier Bell-Zustände, und Bell-Zustandsmessungen (die ermitteln, in welchem der vier Zustände sich ein Quantensystem befindet) sind ein wesentliches Instrument, um die Quantenverschränkung in der Praxis zu nutzen. Am bekanntesten sind vielleicht die Bell-Zustandsmessungen als zentrale Komponente der Quantenteleportation, die wiederum die meisten Verfahren der Quanteninformatik und der Quantenkommunikation möglich macht.

In der Praxis stellt sich jedoch ein Problem: Wenn Experimente mit herkömmlichen optischen Elementen wie Spiegeln, Strahlteilern und Wellenplatten durchgeführt werden, dann zeigen zwei der vier Bell-Zustände identische Messmuster und sind daher nicht voneinander zu unterscheiden. Das bedeutet, dass die Gesamterfolgswahrscheinlichkeit (und damit die Erfolgsrate z. B. eines Quantenteleportationsexperiments) auf 50 Prozent begrenzt ist, wenn nur solche "linearen" optischen Komponenten verwendet werden. Oder doch nicht?

Mittels Hilfsphotonen über die 50-Prozent-Grenze

Hier kommt die Arbeit der Gruppe um Prof. Barz an der Universität Stuttgart ins Spiel. Wie sie kürzlich in der Fachzeitschrift Science Advances berichteten, führten die Doktoranden Matthias Bayerbach und Simone D'Aurelio Bell-State-Messungen durch, bei denen sie eine Erfolgsquote von 57,9 Prozent erzielten. Doch wie konnten sie eine Effizienz erzielen, die mit den vorhandenen Mitteln eigentlich nicht erreichbar sein sollte?

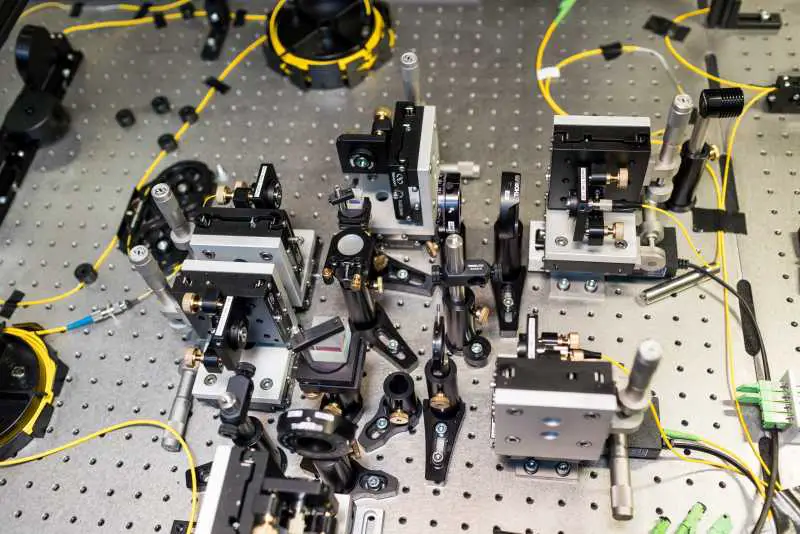

Das Ergebnis wurde durch die Verwendung von zwei zusätzlichen Photonen in Verbindung mit dem verschränkten Photonenpaar ermöglicht. In der Theorie war bekannt, dass solche „Hilfsphotonen“ eine Möglichkeit bieten, Bell-Zustandsmessungen mit einer Effizienz von über 50 Prozent durchzuführen. Eine experimentelle Umsetzung ließ jedoch auf sich warten. Ein Grund dafür ist, dass hochentwickelte Detektoren benötigt werden, welche genau ermitteln können, wie viele Photonen bei ihnen ankommen. Bayerbach und D'Aurelio meisterten diese Herausforderung, indem sie 48 Einzelphotonendetektoren einsetzten, die nahezu perfekt synchron arbeiteten, um die genauen Zustände von bis zu vier Photonen zu erkennen, die am Detektor-Array ankommen.

Auf diese Weise konnte das Team für jeden Bell-Zustand eine andere Verteilung der Photonenzahl nachweisen – wenn auch mit einer gewissen Überlappung der beiden ursprünglich nicht unterscheidbaren Zustände, weshalb die Erfolgswahrscheinlichkeit selbst in der Theorie 62,5 Prozent nicht übersteigen konnte. Die 50-Prozent-Grenze aber wurde geknackt. Darüber hinaus kann die Erfolgswahrscheinlichkeit im Prinzip beliebig nahe bei 100 Prozent liegen, allerdings muss dafür eine höhere Anzahl von Hilfsphotonen eingesetzt werden.

Vielversprechende Aussichten

Auch das ausgefeilteste Experiment ist nicht perfekt, und diese Tatsache muss bei der Analyse der Daten und der Vorhersage, wie die Technik bei größeren Systemen funktionieren würde, berücksichtigt werden. Die Stuttgarter Forschenden haben sich daher mit Prof. Dr. Peter van Loock zusammengetan, einem Theoretiker an der Johannes Gutenberg-Universität Mainz und einem der Architekten des neuartigen Bell-State-Messverfahrens. Van Loock und Barz sind beide Mitglieder der vom BMBF geförderten PhotonQ-Kollaboration, in der akademische und industrielle Partner aus ganz Deutschland zusammenarbeiten, um einen speziellen Typ von photonischen Quantencomputern zu realisieren. Das verbesserte Verfahren für Bell-Zustandsmessungen ist nun eines der ersten Ergebnisse dieser Zusammenarbeit.

Die Effizienzsteigerung von 50 auf 57,9 Prozent mag zwar bescheiden erscheinen, bietet aber einen enormen Vorteil in Szenarien, in denen eine Reihe von aufeinanderfolgenden Messungen durchgeführt werden müssen, zum Beispiel bei der Quantenkommunikation über große Entfernungen. Für eine solche Hochskalierung ist es essenziell, dass der Versuchsaufbau ausschließlich aus linearen Komponenten besteht, weil dadurch die Skalierbarkeit gewährleistet ist. Dies ist bei anderen Ansätzen mit komplexeren Bausteinen nicht der Fall.

Methoden, wie sie Barz und ihr Team jetzt etabliert hat, erweitern unser Instrumentarium, um die Quantenverschränkung in der Praxis sinnvoll zu nutzen – Möglichkeiten, die in der lokalen Quanten-Community in Stuttgart und in Baden-Württemberg unter dem Dach von Initiativen wie der langjährigen Forschungspartnerschaft IQST und dem kürzlich gegründeten Netzwerk QuantumBW intensiv erforscht werden.

Forschungsförderung

Die Arbeiten wurden von der Carl-Zeiss-Stiftung, dem Zentrum für Integrierte Quantenwissenschaften und -technologie (IQST), der Deutschen Forschungsgemeinschaft (DFG), dem Bundesministerium für Bildung und Forschung (BMBF, Projekte SiSiQ und PhotonQ) und dem Bundesministerium für Wirtschaft und Klimaschutz (BMWK, Projekt PlanQK) unterstützt.

Diese Newsmeldung wurde mit Material der Universität Stuttgart via Informationsdienst Wissenschaft erstellt.